在 6 月 2 日举行的 COMPUTEX 大会上,NVIDIA 宣布其加速平台已全面投入生产,无论是通过具有大量 NVIDIA RTX 驱动功能的 AI PC 和消费设备,还是通过 NVIDIA 全栈计算平台构建和部署 AI 工厂的企业,NVIDIA 都在推动技术的边界。

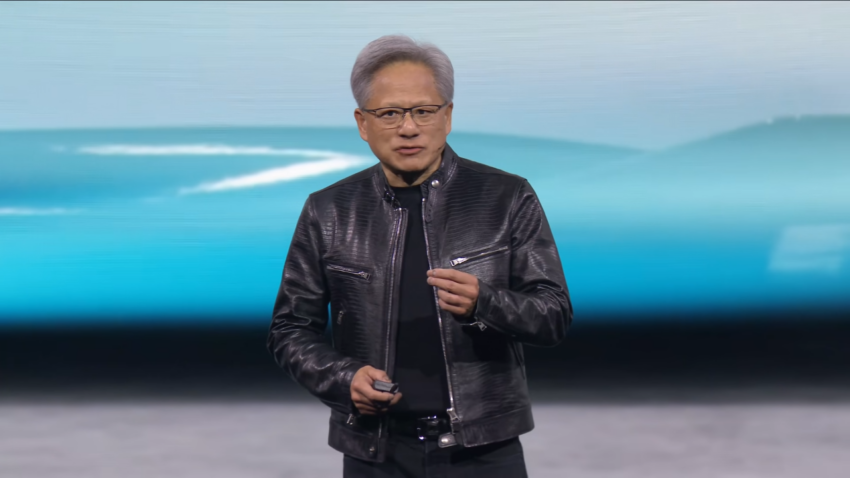

黄仁勋在演讲中表示:“计算的未来正在加速发展。凭借我们在人工智能和加速计算方面的创新,我们正在突破可能的界限,推动下一波技术进步。”

加速计算是一种利用 GPU(图形处理单元)和其他硬件加速器来提高计算速度和效率的技术。与传统的 CPU(中央处理单元)相比,GPU 可以同时处理更多的计算任务,因此在处理大型数据集和复杂计算时,GPU 的表现更为优越。

NVIDIA 的加速计算平台包括其 RTX 系列 GPU,这些 GPU 专为高性能计算和深度学习任务而设计。通过加速计算,企业可以更快地处理数据、训练 AI 模型,并将这些模型应用于实际场景,如图像识别、自然语言处理和自动驾驶等领域。

黄仁勋在演讲中还强调了加速计算的可持续性。他指出,通过结合 GPU 和 CPU,企业可以实现高达 100 倍的计算加速,而功耗仅增加三倍,每瓦性能比单独使用 CPU 提高 25 倍。这意味着加速计算不仅提高了计算效率,还显著降低了能源消耗和运营成本。

黄仁勋总结道:“加速计算是可持续计算。” 他进一步解释说,随着企业购买更多的加速计算设备,他们将能够节省更多的成本和能源,“买得越多,省得越多”,从而实现更高的投资回报率。

Rubin 平台首次亮相,将接替 Blackwell

黄仁勋在大会上透露了 NVIDIA 的新半导体路线图,该路线图将以一年的节奏推出新的技术。

Rubin 平台首次亮相,将接替即将推出的 Blackwell 平台,配备新的 GPU、新的基于 Arm 的 CPU — Vera — 以及采用 NVLink 6、CX9 SuperNIC 和 X1600 融合 InfiniBand/以太网交换机的高级网络。

黄仁勋解释道:“我们公司的节奏是一年。我们的基本理念非常简单:建立整个数据中心规模,以一年的节奏分解并向您出售零件,并将一切推向技术极限。” 以下是产品的推出节奏:

- 2024 年,Blackwell 芯片已经开始生产;

- 2025 年,推出 Blackwell Ultra 产品;

- 2026 年,推出 Rubin 产品;

- 2027 年,推出 Rubin Ultra 产品。

Rubin 平台结合了最新的硬件和软件技术,旨在提供卓越的计算性能和能效。以下是 Rubin 平台的一些关键性能参数和特点:

- 新型 GPU:Rubin 平台配备了最新一代的 GPU,这些 GPU 基于 NVIDIA 最新的架构,提供更高的计算能力和能效。与前代产品相比,新的 GPU 在处理复杂计算任务时表现更加出色。

- Vera CPU:Rubin 平台引入了新的基于 Arm 架构的 CPU——Vera。Vera CPU 具有高性能和低功耗的特点,能够在各种计算任务中提供卓越的表现。Arm 架构的优势在于其灵活性和可扩展性,使得 Rubin 平台在处理多样化的工作负载时具有显著优势。

- 高级网络技术:Rubin 平台采用了 NVLink 6、CX9 SuperNIC 和 X1600 融合 InfiniBand/以太网交换机的高级网络技术。这些技术提升了数据传输速度和网络性能,使得 Rubin 平台在处理大规模数据和复杂计算任务时表现更加优越。

- 高效能与低延迟:Rubin 平台设计时充分考虑了高效能与低延迟的需求,其架构优化使得数据处理更加高效,系统响应速度更快,适用于需要实时数据处理的应用场景。

- 可扩展性:Rubin 平台具有高度的可扩展性,能够满足不同规模企业的需求。从小型数据中心到大型企业级计算环境,Rubin 平台都能提供稳定可靠的性能支持。

在 Rubin 平台之前,Blackwell 平台已被广泛认为是高性能计算和人工智能领域的一大突破。Blackwell 平台的主要特点包括:

- 高性能 GPU:Blackwell 平台采用先进的 GPU 架构,支持高达 20 petaflops 的计算能力,提供强大的计算性能和高效能。

- 内存和带宽:Blackwell 平台配备 384GB 的内存和 16 TB/s 的带宽,使其能够处理大规模的数据和复杂计算任务。

- 高能效和低功耗:Blackwell 平台的设计注重能效优化,最大功耗为 2700W,确保系统在高负载运行时仍能保持低能耗和稳定性能。

构建 AI 工厂:推动新工业革命

领先的计算机制造商,尤其是全球 IT 中心台湾的制造商,已采用 NVIDIA GPU 和网络解决方案。这些公司包括华擎、华硕、技嘉、鸿毅科技、英业达、和硕、QCT、美超微、纬创资通和纬颖科技,它们正在创建云、本地和边缘人工智能系统。

NVIDIA 的 MGX 模块化参考设计平台现在支持 Blackwell,包括 GB200 NVL2 平台,该平台旨在实现大型语言模型推理、检索增强生成和数据处理方面的最佳性能。通过这些技术集成,企业能够更快地部署 AI 应用,提高生产效率,降低运营成本。

包括富士康、和硕及纬创在内的众多电子制造和自动化专家在台北的 COMPUTEX 上展示了他们使用 NVIDIA 软件的最新成果,这些公司展示了从自动化产品制造到改善工人安全和设备性能的计算机视觉和生成式 AI 最新技术。

Foxconn 和其子公司 Ingrasys 正在利用 Omniverse 和 Metropolis 来创建和管理工厂的数字孪生体。这些虚拟模型帮助他们在虚拟环境中进行操作优化和安全管理。具体应用包括:

- 工厂布局优化:通过创建工厂的数字孪生体,Foxconn 可以在虚拟环境中测试和优化生产线布局,减少物流成本,提高生产效率。

- 实时监控和维护:利用 Metropolis 平台,Foxconn 可以实时监控工厂的运行状况,识别潜在问题并进行预防性维护,减少停机时间。

- 员工安全管理:数字孪生体结合视频分析技术,可以实时监控工厂中的安全隐患,如未戴安全帽的工人或设备故障,及时发出警报并采取措施,确保工人安全。

在 COMPUTEX 上,Foxconn 展示了如何使用数字孪生体来规划工厂中多个摄像头的位置,以优化数据捕获并收集关键见解。例如,通过模拟不同摄像头位置和视角,Foxconn 可以确定最佳配置,以最大化覆盖范围和数据质量,提高整体监控效果。

NVIDIA Omniverse 是一个开源平台,旨在实现实时 3D 设计协作和物理准确的仿真。它使多个设计师和工程师能够在同一个虚拟空间中同时工作,实时更新和调整设计内容。对于制造业,Omniverse 提供了一个强大的工具,帮助企业创建和管理复杂的数字孪生体。

Omniverse 的核心功能包括:

- 实时协作:多个用户可以在同一个虚拟环境中实时协作,进行设计和调整,提高工作效率。

- 物理仿真:利用 NVIDIA 的物理引擎,Omniverse 能够进行高度精确的物理仿真,确保虚拟模型与现实世界的行为一致。

- 兼容性:支持多种 3D 设计工具和软件,使得现有的设计流程可以无缝集成到 Omniverse 平台中。

黄仁勋此次宣布了正在和全球领先的工程仿真软件公司 Ansys 合作,并将 Ansys 连接到 Ominiverse 数字孪生系统。同时,黄仁勋还宣布了和全球领先的电子设计自动化(EDA)和半导体知识产权(IP)公司 Synopsys 合作,一旦通过软件定义,下一步就将用生成式 AI 应用于半导体制作领域,进一步突破几何极限。 另外,第三家合作公司则是全球领先的电子设计自动化(EDA)软件和工程服务公司 Cadence。

NVIDIA Metropolis 则是一个用于智能城市和智能工厂的 AI 平台,旨在通过计算机视觉和深度学习技术,分析和理解视频数据。Metropolis 平台能够处理来自数百万台摄像头和传感器的数据,提供实时监控和分析,帮助企业优化运营和提高安全性。

Metropolis 的关键功能包括:

- 视频分析:利用 AI 技术分析实时视频流,识别并标记关键事件和行为。

- 数据整合:整合来自多个来源的数据,提供全面的运营视图和见解。

- 高效处理:利用 NVIDIA 的 GPU 技术,实现高速处理和分析,确保实时响应和决策。

生成式 AI 正在各行业创造生产力飞跃。研究机构麦肯锡预测,生成式 AI 将为先进制造业带来高达 2900 亿美元的价值,同时每年为全球经济带来 4.4 万亿美元的收益。

一年一更,黄仁勋公布 Spectrum-X 产品发布计划

在网络方面,黄仁勋公布了每年发布 Spectrum-X 产品的计划,以满足人工智能对高性能以太网网络不断增长的需求。

NVIDIA Spectrum-X 是首款专为 AI 打造的以太网结构,其网络性能比传统以太网结构提高了 1.6 倍。 它加速了人工智能工作负载的处理、分析和执行,进而加速了人工智能解决方案的开发和部署。

以太网是一种广泛使用的局域网技术,能够在设备之间快速传输数据。对于人工智能应用而言,大量数据的快速传输和处理至关重要,以太网能够提供稳定且高速的连接,确保数据在设备之间高效流动,从而提高计算速度和系统的整体性能。

NVIDIA Spectrum-X 提供了多项先进功能,包括:

- 高性能网络:Spectrum-X 提供了比传统以太网高 1.6 倍的网络性能,显著提高了数据传输速度。

- 低延迟:它具有低延迟特性,能够快速响应数据请求,适用于需要实时数据处理的 AI 应用。

- 高可靠性:提供了可靠的网络连接,确保数据在传输过程中不丢失,提高了系统的稳定性。

在高性能以太网市场,NVIDIA Spectrum-X 面临来自 Intel 和 Mellanox 的竞争。Intel 的 Omni-Path 和 Mellanox 的 InfiniBand 都是市场上著名的高性能网络解决方案。

CoreWeave、GMO Internet Group、Lambda、Scaleway、STPX Global 和 Yotta 是首批采用 Spectrum-X 为其 AI 基础设施带来极致网络性能的 AI 云服务提供商。

NVIDIA NIM:新一代 AI 开发工具

借助 NVIDIA NIM,全球 2800 万开发人员现在可以轻松创建生成式 AI 应用程序。NIM(提供模型作为优化容器的推理微服务)可以部署在云、数据中心或工作站上。 NIM 还使企业能够最大化其基础设施投资。例如,在 NIM 中运行 Meta Llama 3-8B 在加速基础设施上产生的生成性 AI 代币比没有 NIM 时多出 3 倍。

NVIDIA NIM 将与 KServe 集成,KServe 是一种开源软件,能够自动化部署 AI 模型,并确保生成式 AI 像其他大型企业应用一样部署。通过 NIM,企业可以轻松调用 API 来获取 NVIDIA AI Enterprise 软件平台的性能、支持和安全性。

KServe 起源于 Kubeflow,这是一种基于 Kubernetes 的机器学习工具包,旨在部署和管理包含所有组件的大型分布式应用。KServe 通过标准协议运行,并支持 PyTorch、Scikit-learn、TensorFlow 和 XGBoost 等 AI 框架,使用户无需了解这些 AI 框架的细节即可使用。

KServe 的许多公司贡献者和用户包括 AWS、Bloomberg、Canonical、Cisco、Hewlett Packard Enterprise、IBM、Red Hat、Zillow 和 NVIDIA。KServe 作为 Kubernetes 的扩展,可以像强大的云应用程序一样运行 AI 推理,使用标准协议运行,优化性能,并支持多种 AI 框架,如 PyTorch、Scikit-learn、TensorFlow 和 XGBoost,用户无需了解这些框架的细节即可使用。

NIM 提供了优化的推理微服务,这些服务可以部署在各种环境中,包括云、数据中心和边缘设备。 NIM 通过标准化的 API 调用,使企业能够轻松集成和管理其 AI 模型,确保高性能和高效能。

KServe 的“canary rollouts”功能可以自动化验证和逐步部署更新版本的模型,GPU 自动缩放功能则高效管理模型部署的资源需求,确保在服务需求波动时,客户和服务提供商能够获得最佳体验。

通过与 KServe 的结合,NIM 可以简化生成式 AI 应用的部署和管理,使开发人员能够专注于应用程序本身,而无需担心底层的基础设施复杂性。这种集成使得生成式 AI 应用能够像任何其他大型企业应用一样被部署和管理,提升了企业的运营效率和创新能力。

NIM 还通过其优化的性能和支持,提供了强大的安全性和可靠性,确保企业在部署和运行生成式 AI 应用时能够获得最佳效果。

NVIDIA NIM 的竞争优势在于其深度集成的硬件和软件生态系统,以及与 KServe 的无缝集成。 NIM 利用 NVIDIA 的 GPU 技术,实现高效的模型推理和管理,同时提供了强大的性能和可扩展性。

此外,NVIDIA NIM 的标准化 API 调用和优化性能,使企业能够轻松集成和管理 AI 模型,确保高效能和高可靠性。通过与多家平台的合作,NIM 能够广泛部署在云、数据中心和边缘设备上,为企业提供灵活的部署选择。

写在最后

NVIDIA 作为全球领先的人工智能和加速计算公司,市值已超过 2.7 万亿美元,成为全球最有价值的科技公司之一。

NVIDIA 的 Rubin 平台和 Spectrum-X 技术的发布,再次展示了其在高性能计算和人工智能领域的领先地位。通过不断创新和技术升级,NVIDIA 不仅提升了产品的性能和能效,还为用户提供了更高的灵活性和扩展性。专家和媒体对这些新技术的积极评价进一步证明了 NVIDIA 的技术实力和市场影响力。随着这些技术的广泛应用,NVIDIA 将继续引领技术革新,为全球用户提供更加先进和高效的计算解决方案。